ИНФОРМАЦИЯ

в

кибернетике. Естественнонаучное понимание И. основано на двух определениях

этого понятия, предназначенных для различных целей (для информации теории,

иначе называемой статистич. теорией связи, и теории статистических оценок).

К ним можно присоединить и третье (находящееся в стадии изучения), связанное

с понятием сложности алгоритмов.

Центральное

положение понятия И. в кибернетике объясняется тем, что кибернетика (ограничивая

и уточняя интуитивное представление об И.) изучает машины и живые организмы

с точки зрения их способности воспринимать определённую И., сохранять её

в "памяти", передавать по "каналам связи"- и перерабатывать её в "сигналы",

направляющие их деятельность в соответствующую сторону.

В нек-рых случаях

возможность сравнения различных групп данных по содержащейся в них И. столь

же естественна, как возможность сравнения плоских фигур по их "площади":

независимо от способа измерения площадей можно сказать, что фигура А имеет

не большую площадь, чем В, если А может быть целиком помещена в В (ср.

примеры 1-3 ниже). Более глубокий факт - возможность выразить площадь числом

и на этой основе сравнить между собой фигуры произвольной формы - является

результатом развитой математич. теории. Подобно этому, фундаментальным

результатом теории И. является утверждение о том, что в определённых весьма

широких условиях можно пренебречь качественными особенностями И. и выразить

её количество числом. Только этим числом определяются возможности передачи

И. по каналам связи и её хранения в запоминающих устройствах.

Пример 1. В

классической механике знание положения и скорости частицы, движущейся в

силовом поле, в данный момент времени даёт И. о её положении в любой будущий

момент времени, притом полную в том смысле, что это положение может быть

предсказано точно. Знание энергии частицы даёт И., но, очевидно, неполную.

Пример 2. Равенство

даёт И. относительно

вещественных переменных a и b. Равенство

даёт меньшую

И. [т. к. из (1) следует (2), ио эти равенства не равносильны]. Наконец,

равенство

равносильное

(1), даёт ту же И., то есть (1) и (3) - это различные формы задания одной

и той же И.

Пример 3. Результаты

произведённых с ошибками независимых измерений к.-л. физич. величины дают

И. о её точном значения. Увеличение числа наблюдений увеличивает эту И.

Пример З а.

Среднее арифметическое результатов наблюдений также содержит некоторую

И. относительно рассматриваемой величины. Как показывает математическая

статистика, в случае нормального распределения вероятностей ошибок с известной

дисперсией среднее арифметическое содержит всю И.

Пример 4. Пусть

результатом нек-рого измерения является случайная величина X. При передаче

по нек-рому каналу связи X искажается, в результате чего на приёмном конце

получают величину , где

, где

не зависит от X (в смысле теории вероятностей). "Выход" Y даёт И. о "входе"

X; причём естественно ожидать, что эта И. тем меньше, чем больше дисперсия

случайной ошибки

В каждом из

приведённых примеров данные сравнивались по большей или меньшей полноте

содержащейся в них И. В примерах 1-3 смысл такого сравнения ясен и сводится

к анализу равносильности или неравносильности нек-рых соотношений. В примерах

3 а и 4 этот смысл требует уточнения. Это уточнение даётся, соответственно,

математич. статистикой и теорией И. (для к-рых эти примеры являются типичными).

В основе теории

информации лежит предложенный в 1948 амер. учёным К. Шенноном способ измерения

количества И., содержащейся в одном случайном объекте (событии, величине,

функции и т. п.) относительно др. случайного объекта. Этот способ приводит

к выражению количества И. числом. Положение можно лучше объяснить в простейшей

обстановке, когда рассмаг-риваемые случайные объекты являются случайными

величинами, принимающими лишь конечное число значений. Пусть X - случайная

величина, принимающая значения

с вероятностями < ,

< ,

a

Y - случайная величина, принимающая значения

с вероятностями . Тогда

. Тогда

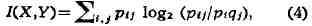

И.I(X,Y) относительно У, содержащаяся в X,

определяется формулой

где Ptj - вероятность

совмещения событий

и логарифмы берутся по основанию 2. И. I(X, Y) обладает рядом свойств,

к-рые естественно требовать от меры количества И. Так, всегда и

и

равенство возможно тогда

возможно тогда

и только тогда, когда

при всех , т. е. когда

, т. е. когда

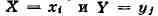

случайные величины X и Y независимы. Далее, всегда

и равенство возможно только в случае, когда Y есть функция от X (напр.,

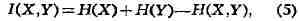

и т. д.). Кроме того, имеет место равенство

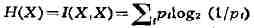

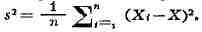

Величина

носит

название энтропии случайной величины X. Понятие энтропии относится к числу

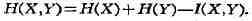

основных понятий теории И. Количество И. и энтропия связаны соотношением

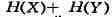

где H (X, У)

- энтропия пары (X, Y), T. е.

Величина

энтропии указывает среднее число двоичных знаков (см. Двоичные единицы),

необходимое для различения (или записи) возможных значений случайной величины

(подробнее см. Кодирование, Энтропия). Это обстоятельство позволяет понять

роль количества И. (4) при "хранения" И. в запоминающих устройствах. Если

случайные величины X и Y независимы, то для записи значения X требуется

в среднем H(X) двоичных знаков, для значения Y требуется H(Y)

двоичных знаков,

а для пары требуется

требуется

двоичных знаков. Если же случайные величины X и Y зависимы, то среднее

число двоичных знаков,< необходимое для записи пары ,

,

оказывается меньшим суммы H(X) + H(Y), т. к.

С помощью

значительно более глубоких теорем выясняется роль количества И. (4) в вопросах

передачи И. по каналам связи. Основная информационная характеристика каналов,

т. н. пропускная способность (или ёмкость), определяется через понятие

"И." (подробнее см. Канал).

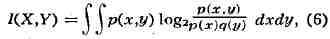

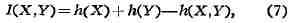

Если X и Y

имеют совместную плотность р(х, у), то

где

буквами р и q обозначены плотности вероятности X и Y соответственно. При

этом энтропии H (X) и H (Y) не существуют, но имеет место формула, аналогичная

(5),

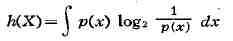

где

дифференциальная

энтропия определяется

определяется

подобным же образом].

Пример 5. Пусть

в условиях примера 4 случайные величины

имеют нормальное распределение вероятностей с нулевыми средними значениями

и дисперсиями, равными соответственно

и

. Тогда, как молено подсчитать по формулам (6) или (7):

Таким

образом, количество И. в "принятом сигнале" Y относительно "переданного

сигнала" X стремится к нулю при возрастании уровня "помех"

(т. е. при ) и неограниченно

) и неограниченно

возрастает при исчезающе малом влиянии "помех" (т. е. при

).

Особенный интерес

для теории связи представляет случай, когда в обстановке примеров 4 и 5

случайные величины X и Y заменяются случайными функциями (или, как говорят,

случайными процессами) X (t) и У (t), к-рые описывают изменение нек-рой

величины на входе и на выходе передающего устройства. Количество И. в Y

(t) относительно X (t) при заданном уровне помех ("шумов", по акустич.

терминологии) может

может

служить критерием качества самого этого устройства (см. Сигнал, Шеннона

теорема).

В задачах математич.

статистики также пользуются понятием И. (ср. примеры 3 и 3 а). Однако как

по своему формальному определению, так и по своему назначению оно отличается

от вышеприведённого (из теории И.). Статистика имеет дело с большим числом

результатов наблюдений и заменяет обычно их полное перечисление указанием

нек-рых сводных характеристик. Иногда при такой замене происходит потеря

И., но при нек-рых условиях сводные характеристики содержат всю И., содержащуюся

в полных данных (разъяснение смысла этого высказывания даётся в конце примера

6). Понятие И. в статистике было введено англ, статистиком P. Фишером в

1921.

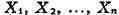

Пример 6. Пусть

- результаты n независимых наблюдений нек-рой величины, распределённые

по нормальному закону с плотностью вероятности

где параметры

(среднее и дисперсия) неизвестны и должны быть оценены по результатам наблюдений.

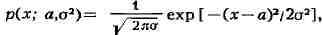

Достаточными статистиками (т. е. функциями от результатов наблюдений, содержащими

всю И. о неизвестных параметрах) в этом примере являются

среднее арифметическое

и т. н. эмпирическая

дисперсия

Если параметр известен,

известен,

то достаточной статистикой будет только X (ср. пример 3 а выше).

Смысл выражения

"вея И." может быть пояснён следующим образом. Пусть имеется к.-л. функция

неизвестных параметров и

и

пусть - к.-л. её оценка,

- к.-л. её оценка,

лишённая система-тич. ошибки. Пусть качество оценки (её точность) измеряется

(как это обычно делается в задачах математич. статистики) дисперсией разности

Тогда существует другая оценка ,

,

зависящая не от отдельных величин Xt, а только от сводных характеристик

X и s2, не худшая (в смысле упомянутого критерия), чем

. P. Фишером была предложена также мера (среднего) количества И. относительно

неизвестного параметра, содержащейся в одном наблюдении. Смысл этого понятия

раскрывается в теории ста-тистич. оценок.

Лит.: Крамер

Г., Математические методы статистики, пер. с англ., M., 1948; Ван-дер-Варден

Б. JI., Математическая статистика, пер. с нем., M., 1960; Кульбак С., Теория

информации и статистика, пер. с англ., M., 1967.

Ю. В. Прохоров.

А Б В Г Д Е Ё Ж З И Й К Л М Н О П Р С Т У Ф Х Ц Ч Ш Щ Ъ Ы Ь Э Ю Я