ИНФОРМАЦИИ ТЕОРИЯ

математя ческая дисциплина, исследующая процессы хранения,

преобразования и передачи информации. И. т. - существенная часть кибернетики.

В основе И. т. лежит определённый способ измерения количества информации,

содержащейся в к.-л. данных ("сообщениях"). И. т. исходит из представления

о том, что сообщения, предназначенные для сохранения в запоминающем устройстве

или для передачи по каналу связи, не известны заранее с полной определённостью.

Заранее известно лишь множество, из к-рого могут быть выбраны эти сообщения,

и в лучшем случае - то, как часто выбирается то или иное из этих сообщений

(т. е. вероятность сообщений). В И. т. показывается, что "неопределённость",

с к-рой сталкиваются в подобной обстановке, допускает количественное выражение

и что именно это выражение (а не конкретная природа самих сообщений) определяет

возможность их хранения и. передачи. В качестве такой "меры неопределённости"

в И. т. принимается число двоичных знаков, необходимое для фиксирования

(записи) произвольного сообщения данного источника. Более точно - рассматриваются

все возможные способы обозначения сообщений цепочками символов 0 и 1 (двоичные

коды), удовлетворяющие условиям: а) различным сообщениям соответствуют

различные цепочки и б) по записи нек-рой последовательности сообщений в

кодированной форме эта последовательность должна однозначно восстанавливаться.

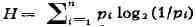

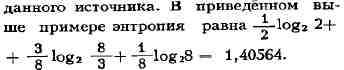

Тогда в качестве меры неопределённости принимают среднее значение длины

кодовой цепочки, соответствующее самому экономному способу кодирования;

один двоичный знак служит единицей измерения (см. Двоичные единицы).

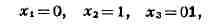

Пример. Пусть

непригоден,

удовлетворяет

Нетрудно понять,

Здесь уместно

Нет никакой

меньше величины (где log С изложенной

Так же как

Понятие канала

И. т. отыскивает

Основы И. т.

Лит.: Яглом

А

Б

В

Г

Д

Е

Ё

Ж

З

И

Й

К

Л

М

Н

О

П

Р

С

Т

У

Ф

Х

Ц

Ч

Ш

Щ

Ъ

Ы

Ь

Э

Ю

Я

нек-рые сообщения x

так как нарушается вышеупомянутое условие б). Так, цепочка 0tl может означать

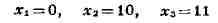

x

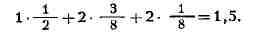

условиям а) и б). Ему соответствует среднее значение длины кодовой цепочки,

равное

что никакой другой код не может дать меньшего значения, т. е. указанный

код - самый экономный. В соответствии с выбором меры неопределённости,

неопределённость данного источника сообщений следует принять равной 1,5

двоичной единицы.

подчеркнуть, что термины "сообщение", "канал связи" и т. п. понимают в

И.

т. очень широко. Так, с точки зрения И. т., источник сообщений описывается

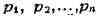

перечислением множества Xi, лг

изображениями и т. п.) и соответствующих Ям вероятностей р

простой формулы, выражающей точный минимум H' среднего числа двоичных знаков,

необходимого для кодирования сообщений

через вероятности  этих

этих

сообщений. Однако указанный минимум не

более чем на единицу. Величина H (энтропия множества сообщений) обладает

простыми формальными свойствами, а для всех выводов И. т., к-рые носят

асимптотический характер, соответствуя случаю

, разница между H и  абсолютно

абсолютно

несущественна. Поэтому именно энтропия принимается в качестве меры неопределённости

сообщений

точки зрения, энтропия бесконечной совокупности оказывается, как правило,

бесконечной. Поэтому в применении к бесконечным совокупностям поступают

иначе. Именно, задаются определённым уровнем точности и вводят понятие

эпсилон - энтропии, как энтропии сообщения, записываемого с точностью до

е, если сообщение представляет собой непрерывную величину или функцию (напр.,

времени); подробнее см. в ст. Энтропия.

и понятие энтропии, понятие количества информации, содержащейся в одном

случайном объекте (случайной величине, случайном векторе, случайной функции

и т. д.) относительно другого, вводится сначала для объектов с конечным

числом возможных значений. Затем общий случай изучается при помощи предельного

перехода. В отличие от энтропии, количество информации, напр., в одной

непрерывно распределённой случайной величине относительно другой непрерывно

распределённой величины очень часто оказывается конечным.

связи (см. Канал) в И. т. носит весьма общий характер. По сути дела, канал

связи задаётся указанием множества "допустимых сообщений" на "входе канала",

множеством "сообщений на выходе" и набором условных вероятностей получения

того или иного сообщения на выходе при данном входном сообщении. Эти условные

вероятности описывают влияние "помех", искажающих передаваемые сообщения.

"Присоединяя" к каналу к.-л. источник сообщений, можно рассчитать количество

информации относительно сообщения на входе, содержащееся в сообщении на

выходе. Верхняя грань таких количеств информации, взятая по всем допустимым

источникам, наз. пропускной способностью (ёмкостью) канала. Ёмкость канала

- его основная информационная характеристика. Несмотря на влияние (возможно

сильное) помех в канале, при определённом соотношении между энтропией поступающих

сообщений и пропускной способностью канала возможна почти безошибочная

передача (при надлежащем кодировании, см. Шеннона теорема).

оптимальные, в смысле скорости и надёжности, способы передачи информации,

устанавливая теоретич. пределы достижимого качества. Как видно из предыдущего,

И. т. носит существенно статистич. характер, и поэтому значительная часть

её математич. методов заимствуется из теории вероятностей.

были заложены в 1948-49 амер. учёным К. Шенноном. В её теоретич. разделы

внесён вклад сов. учёными A. H. Колмогоровым и А. Я. Хинчиным, а в разделы,

соприкасающиеся с применениями, - В. А. Котельниковым, А. А. Харкевичем

и др.

A. M., Яглом И. M., Вероятность и информация, 2 изд., M., 1960; Шэннон

К., Статистическая теория передачи электрических сигналов, в кн.: Теория

передачи электрических сигналов при наличии помех. Сб. переводов, M., 1953;

Голдман С., Теория информации, пер. с англ., M., 1957; Теория информации

и её приложения. Сб. переводов, M., 1959; Xинчин А. Я., Понятие энтропии

в теории вероятностей, "Успехи математических наук", 1953, т. 8, в. 3;

Колмогоров A. H-, Теория передачи информации, M., 1956 (АН СССР. Сессия

по научным проблемам автоматизации производства. Пленарное заседание);

Питерсон У. У., Коды, исправляющие ошибки, пер. с англ., M., 1964. Ю. В.

Прохоров.